AutoML-GPT: Automatic Machine Learning with GPT

提出一种基于大型语言模型的自动机器学习方法AutoML-GPT,利用GPT作为桥梁自动完成各种AI任务的数据处理、模型架构设计和超参数优化等流程,有效提高了训练效率和模型性能。

解决问题: 这篇论文试图解决的问题是如何自动化机器学习的训练过程,以减少人工寻找模型结构、优化算法和超参数的时间和精力。同时,论文还试图验证利用大型语言模型(LLMs)自动化训练的可行性。

论文地址:https://arxiv.org/abs/2305.02499

-

动机:解决人工挑选模型架构、优化算法和超参数等问题,提高训练效率和模型性能。 -

方法:利用GPT作为桥梁自动完成各种AI任务的数据处理、模型架构设计和超参数优化等流程。 -

优势:能通过AutoML-GPT的强大语言能力和现有AI模型解决各种复杂的AI任务,提高训练效率和模型性能。

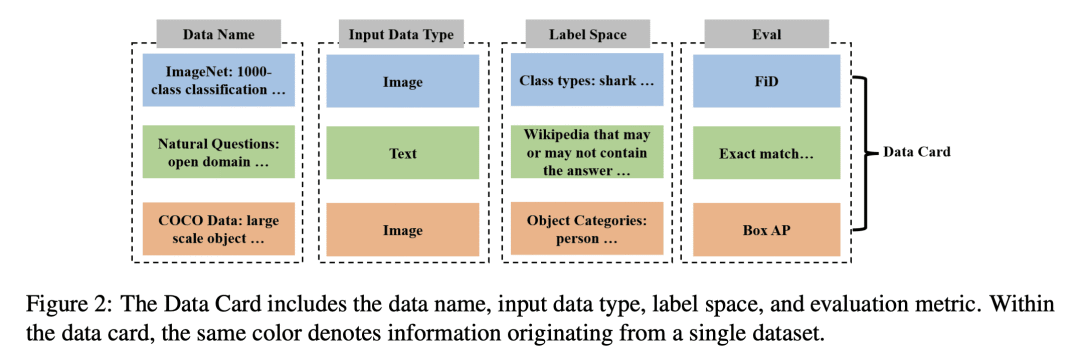

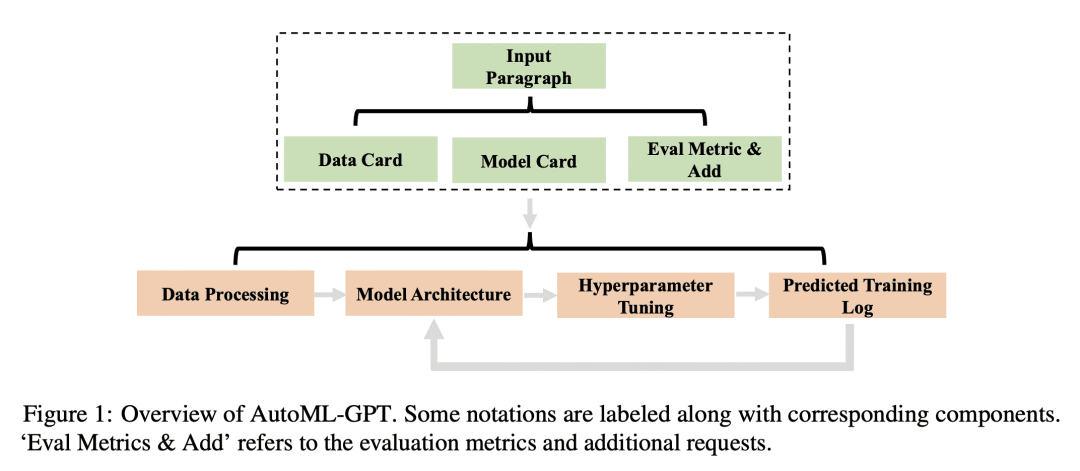

关键思路: 论文的关键思路是使用GPT作为桥梁,将自动化训练的任务分为两个步骤:首先,根据用户请求和数据卡片生成相应的提示段落;然后,利用提示段落自动进行数据处理、模型架构、超参数调整和预测训练日志。相比于当前的研究,论文的思路在于利用LLMs自动生成提示段落,从而实现自动化训练。

其他亮点: 论文的实验设计了多个任务和数据集,包括计算机视觉和自然语言处理等领域,证明了AutoML-GPT的通用性和有效性。此外,论文提供了开源代码。值得继续深入研究的是,如何进一步提高自动生成提示段落的准确性和效率。

关于作者: Shujian Zhang、Chengyue Gong、Lemeng Wu、Xingchao Liu和Mingyuan Zhou均来自南京大学。他们之前的代表作包括:

- Zhang等人在ACL 2020上发表的论文《ERNIE-GEN: An Enhanced Multi-Flow Pre-training and Fine-tuning Framework for Natural Language Generation》

- Gong等人在AAAI 2020上发表的论文《Unsupervised Cross-lingual Representation Learning at Scale》

- Wu等人在EMNLP 2020上发表的论文《Improving Low-resource Named Entity Recognition with Joint Learning and Contrastive Learning》

- Liu等人在ACL 2020上发表的论文《Graph-based Neural Multi-Document Summarization》

- Zhou等人在AAAI 2021上发表的论文《Joint Entity Recognition and Relation Extraction as a Multi-head Selection Problem》

论文摘要:该论文提出了一种名为AutoML-GPT的自动机器学习方法,它利用了大型语言模型(LLMs)如ChatGPT在推理、理解和交互等方面的出色能力,并通过开发面向任务的提示语句,自动利用LLMs来自动化训练流程。AutoML-GPT利用GPT作为桥梁,动态地训练具有优化超参数的各种AI模型。它通过获取用户请求和数据卡,组成相应的提示段落,最终自动从数据处理到模型架构、超参数调整和预测训练日志等方面进行实验。该方法利用了LLMs的强大语言能力和可用的AI模型,可以处理各种复杂的AI任务和数据集,并在计算机视觉、自然语言处理和其他具有挑战性的领域取得了显著的结果。大量实验和消融研究表明,该方法具有普适性、有效性和益处,适用于许多AI任务。