CodeT5+: Open Code Large Language Models for Code Understanding and Generation

Yue Wang, Hung Le, Akhilesh Deepak Gotmare, Nghi D.Q. Bui, Junnan Li, Steven C.H. Hoi

[Salesforce AI Research]

CodeT5+:面向代码理解和生成的开放大型代码语言模型

要点:

-

动机:现有的代码大型语言模型在架构和预训练任务方面存在限制,无法灵活适应不同的下游代码任务,并在某些任务上达到最佳性能。 -

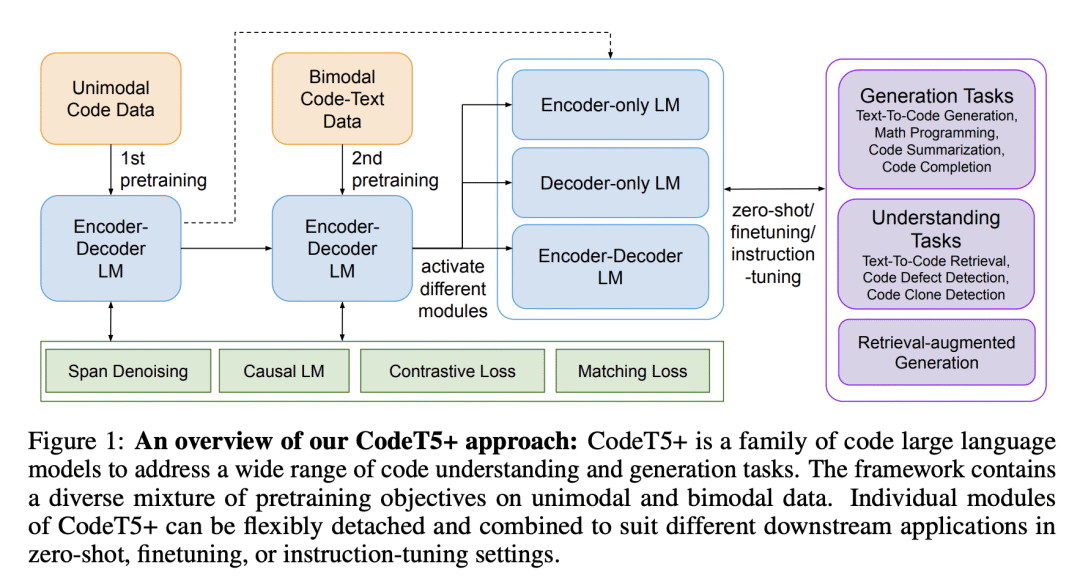

方法:提出“CodeT5+”,一种用于代码的编-解码大型语言模型族,可以灵活组合组件模块以适应各种下游代码任务,并使用多样的预训练目标来减轻预训练-微调差异。 -

优势:CodeT5+具有灵活的架构和丰富的预训练任务,能在各种代码相关任务上实现领先的性能,包括代码生成、数学编程和文本到代码检索等。

论文地址:https://arxiv.org/abs/2305.07922

提出CodeT5+,一种灵活的编解码大型语言模型,通过多样的预训练任务和灵活的架构,实现了在各种代码任务上的领先性能。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...