Improving Language Model Negotiation with Self-Play and In-Context Learning from AI Feedback

Yao Fu, Hao Peng, Tushar Khot, Mirella Lapata

[University of Edinburgh & Allen Institute for AI]

通过自弈和从AI反馈中学习的上下文学习提高语言模型谈判能力

要点:

-

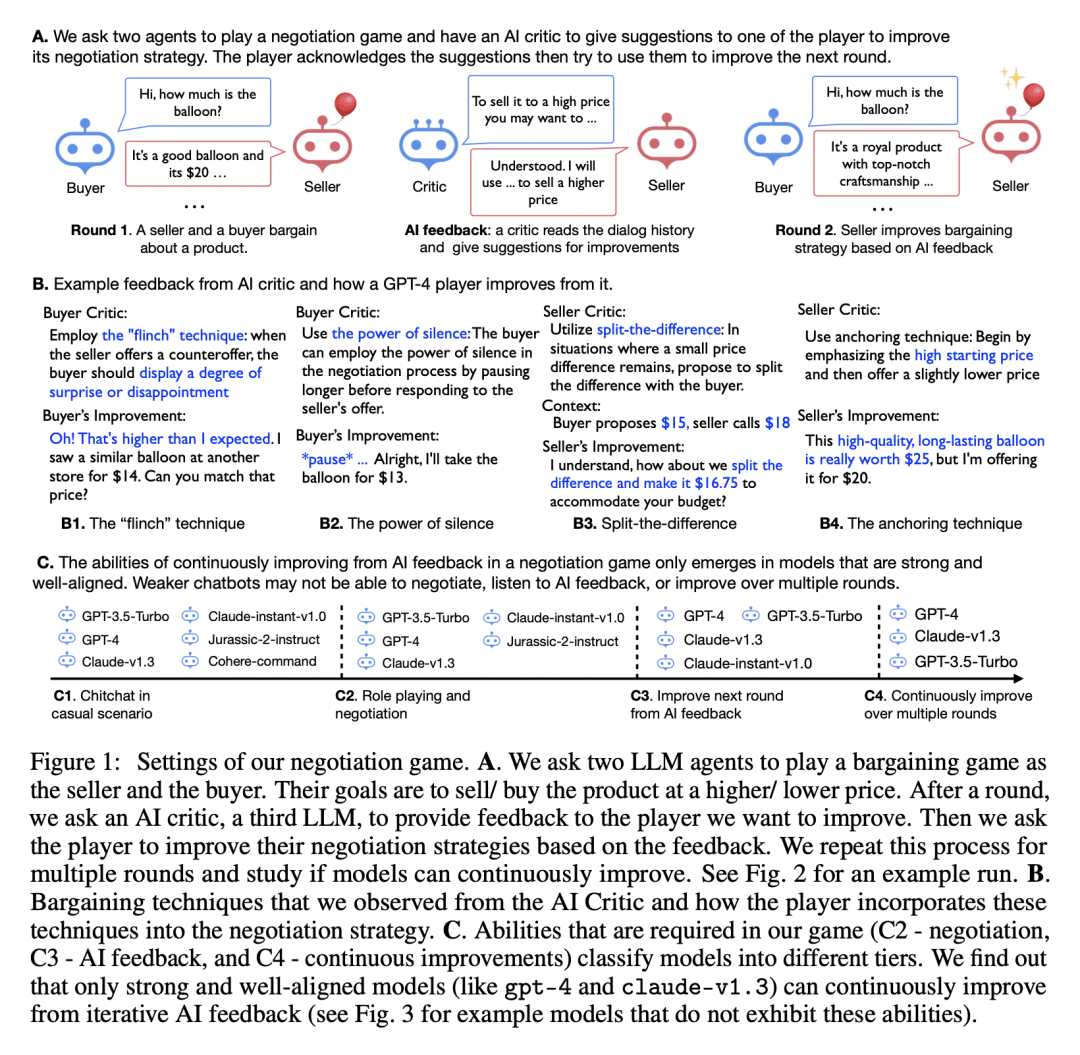

动机:研究多个大型语言模型在谈判博弈中是否能够通过扮演角色、学习AI反馈来自主改进彼此。研究该问题的原因在于,如果语言模型能够相互改进,将意味着可以创建具有最少人工干预的强大AI智能体。 -

方法:通过让两个语言模型扮演买家和卖家的角色,在谈判过程中相互交互,并引入第三个语言模型作为批评者,提供反馈以改进谈判策略。利用先前的谈判历史和AI反馈作为上下文演示,迭代地改进模型的谈判策略。在不同的角色中使用不同的语言模型,并以成交价格作为评估指标。 -

优势:实验证明,某些语言模型能够通过不断进行竞争性博弈并获得迭代的AI反馈,从而自主改进。同时,研究还揭示了在多轮博弈中,模型在提高下一轮价格和成功率之间的权衡,更好的价格也意味着更高的交易风险。这表明未来的研究可以考虑在多轮中进行全局优化,以提高整体收益。此外,论文还展示了从迭代AI反馈中改进语言的证据。相信这项工作对于AI研究具有深远的影响,它既展示了语言模型在最小人工干预下不断改进的可能性,又提示了在多Agent博弈设置下需要进一步研究模型行为监督和安全性的挑战。

通过博弈和AI反馈学习,多个大型语言模型在谈判游戏中能实现自主改进,但同时需要权衡价格抬高和交易风险,对AI研究具有深远的意义。

https://arxiv.org/abs/2305.10142

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...