Language Models Meet World Models: Embodied Experiences Enhance Language Models

Jiannan Xiang, Tianhua Tao, Yi Gu, Tianmin Shu, Zirui Wang, Zichao Yang, Zhiting Hu

[UC San Diego & UIUC & MIT & CMU]

用世界模型增强语言模型: 用具身体验增强语言模型

要点:

-

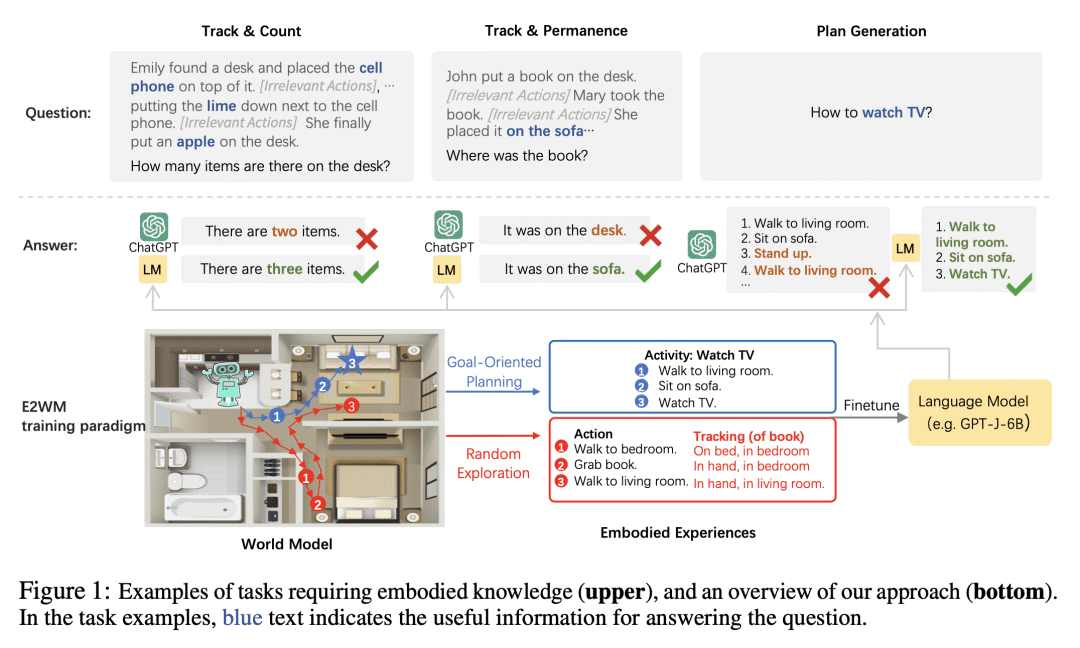

动机:大型语言模型在许多任务上显示出卓越的能力,但在物理环境中进行简单的推理和规划(如理解物体的持久性或规划居家活动)方面常常存在困难。这是因为语言模型仅在书面文本上进行训练,缺乏实际的体验和技能。因此,本文旨在通过世界模型的微调,增强语言模型并获得多样化的具身知识,同时保留其通用的语言能力。

-

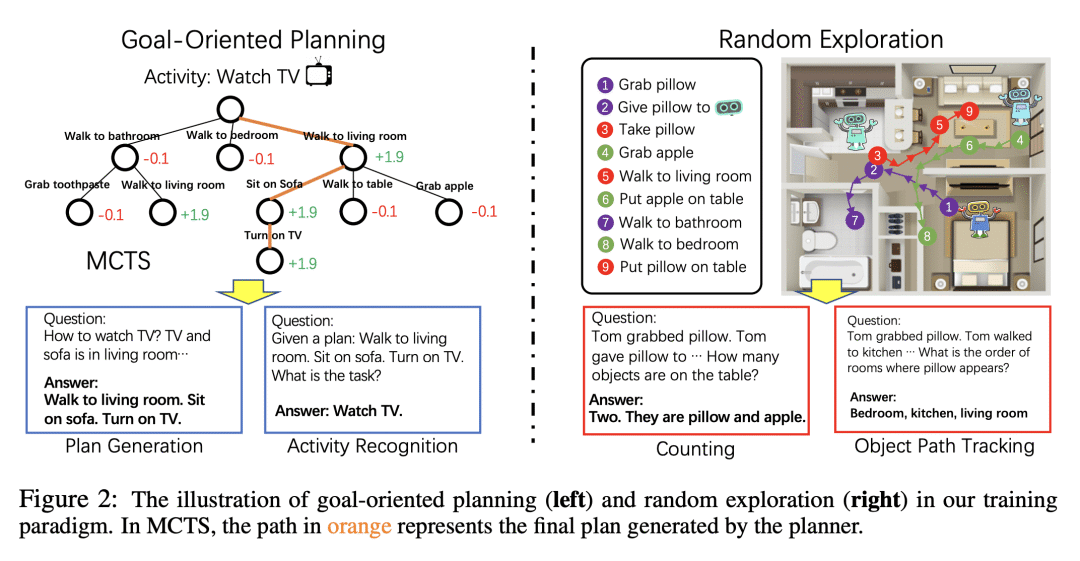

方法:在世界模型中部署一个实体化智能体(VirtualHome)进行目标导向的规划和随机探索,以获取多样化的具身化经验。然后,使用这些经验对语言模型进行微调,教授其在物理世界中进行推理和行动的多种能力,如规划和完成目标、物体持久性和跟踪等。为了保留语言模型的泛化性,在微调过程中引入经典的弹性权重整合(EWC)和低秩适配器(LoRA)等技术。

-

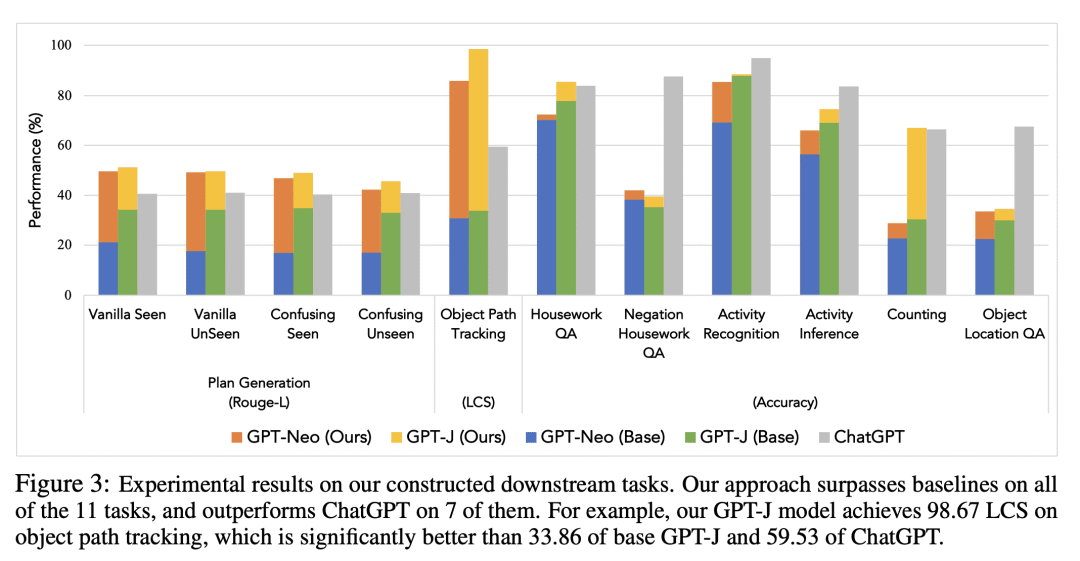

优势:通过世界模型的微调,显著提升了基础语言模型在18个下游任务上的表现,平均提高了64.28%。特别是通过所提出的方法增强的小型语言模型(1.3B和6B)与更大的语言模型(如ChatGPT)相媲美甚至超过其性能。

一句话总结:

通过世界模型的微调,提升语言模型在物理环境中推理和规划任务的能力,在多个下游任务中取得显著性能提升。

https://arxiv.org/abs/2305.10626

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...