Transformer出现以前,人工智能的各个领域(自然语言处理、计算机视觉等)是兄弟爬山,各自努力。每个领域都有自己的模型框架。如今Transformer已经一统天下–包括目前火热的ChatGPT。作为一种具有更高普适性的AI模型架构,其必然蕴含有更为深邃的原理和思想,值得我们深入研究和领悟。

介绍Transformer的文章很多,但绝大部分是从谷歌的原始论文开始讲起。原始的模型是针对自然语言处理构建的,要深刻理解模型需要有一定的语言学的先验知识,以及海量的语料库数据,这些对于初学者来说是比较困难的。

我认为既然如今Transformer已经可以适用于AI的所有领域,应当有一些实验案例,剥离那些来自专业领域的先验知识,专门聚焦研究Transformer的原理与思想,以便我们能将这些原理与思想应用到新的任务中。

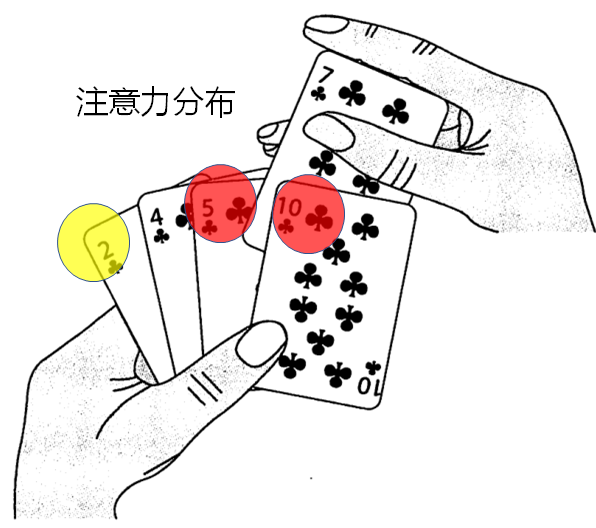

我在百度、GitHub上找了很多遍,一直没有找到这样的案例。因此本人决定利用假期时间,自己设计一个这样的案例。本人决定将案例设定为对扑克牌排序。

详情请见:AI是如何学习扑克牌排序的(一)

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...