AttentionViz: A Global View of Transformer Attention

Catherine Yeh, Yida Chen, Aoyu Wu, Cynthia Chen, Fernanda Viégas, and Martin Wattenberg

哈佛大学

解决问题:

这篇论文试图解决Transformer模型中的自注意力机制的可解释性问题,旨在帮助研究人员理解这种机制如何使模型学习序列中元素之间的丰富、上下文关系。这可以帮助研究人员更好地理解模型的内部工作原理,从而提高模型的性能和鲁棒性。

关键思路:

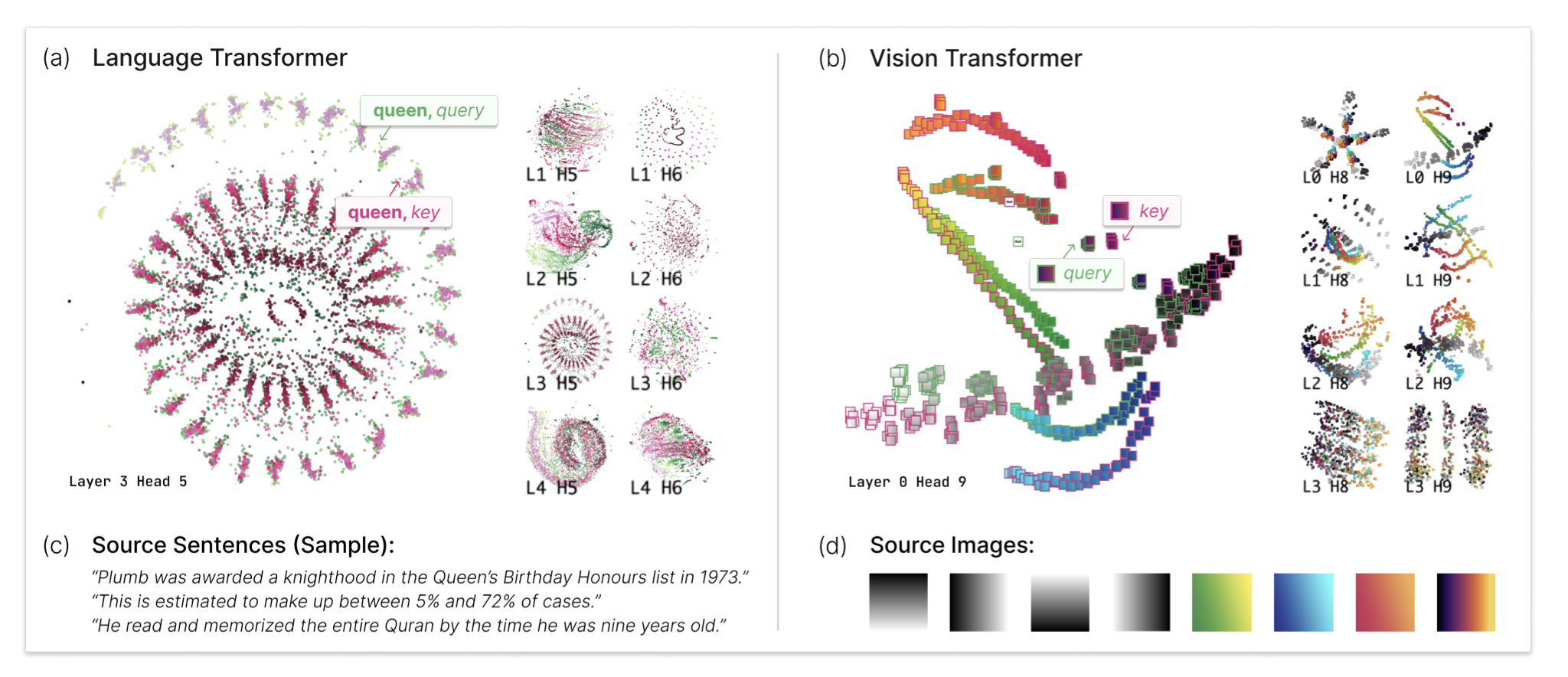

论文提出了一种新的可视化技术,用于帮助研究人员理解Transformer模型中的自注意力机制。该技术的主要思路是可视化Transformer模型中用于计算注意力的查询和键向量的联合嵌入。与以往的注意力可视化技术不同,该方法可以分析多个输入序列之间的全局模式。作者们基于这种联合查询-键嵌入创建了一个交互式的可视化工具AttentionViz,并使用它来研究语言和视觉Transformer中的注意力机制。作者们通过几个应用场景和专家反馈证明了他们的方法在提高模型理解和提供有关查询-键交互的新见解方面的实用性。

其他亮点:

该论文的实验设计精细,使用了多个数据集,并提供了开源代码。这个方法还可以应用于其他类型的序列数据,如音频和时间序列。这篇论文的新颖之处在于它提供了一种全局视角,可以更好地理解Transformer模型中的自注意力机制,从而提高模型的可解释性和性能。

相关研究:

近期其他相关的研究包括:“Interpretable and Fine-grained Visual Explanations for Convolutional Neural Networks via Input Splitting”(作者:Jing Zhang等,机构:香港中文大学)、“Attention Is Not Explanation”(作者:Sahil Singla等,机构:加州大学伯克利分校)、“Towards Explainable and Controllable Dialogue Generation with Auxiliary Task of Sentiment Classification”(作者:Yunyi Zhang等,机构:南京大学)等。

论文摘要:

本文中,我们介绍了一种新的可视化技术,旨在帮助研究人员了解Transformer模型中的自注意机制,该机制使得这些模型能够学习序列中元素之间丰富的上下文关系。我们的方法的主要思想是可视化Transformer模型用于计算注意力的查询和键向量的联合嵌入。与以前的注意力可视化技术不同的是,我们的方法能够分析多个输入序列之间的全局模式。我们基于这些联合查询-键嵌入创建了一个交互式可视化工具AttentionViz,并使用它来研究语言和视觉Transformer中的注意力机制。我们通过多个应用场景和专家反馈展示了我们方法的实用性,提高了模型的理解,并提供了有关查询-键交互的新见解。