【论文速读】是OpenBMB发起的大模型论文学习栏目,用 高效的思维导图 形式,带领大家在 10min 内快速掌握一篇 前沿经典 论文。我们邀请来自清华大学自然语言处理实验室以及各大高校、科研机构的 学术达人 作为主讲人分享 大模型领域论文。

01 作者信息

-

Jason Wei:Google Research 高级研究员,主要研究大模型 scaling,是inverse scaling 的发现者 -

Yi Tay:Google Researc 研究员,主要研究大模型 scaling、efficient transformers

-

Percy Liang:Stanford

-

Jeff Dean :Google Brain

02 论文简介

-

下游任务能力在大模型上的不可预测性

-

不能从小模型的的性能外推

-

是否能通过继续扩大模型规模来获得更多涌现能力

03 研究设计

-

通常的涌现现象:系统中的定量变化导致行为的质变。 -

大模型的涌现现象:能力不存在于较小的模型中,而是存在于较大的模型中。

-

Performance 和 FLOPs(计算量)的关系

-

Performance 和 Model Parameters 的关系

-

叠甲:emergent 与很多因素有关,本文指 emergent 现象普遍存在。

04 实验及结果

-

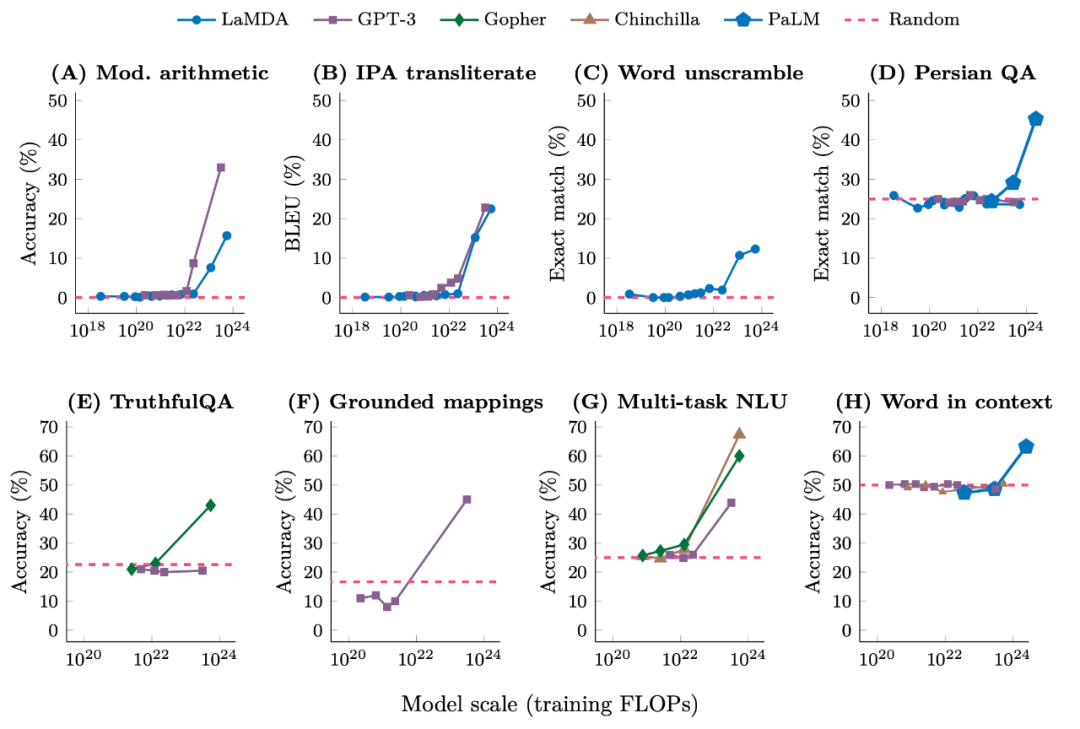

上图 A-H 这些 task 以 fewshot 形式展示过以后都有 emergent

-

不同模型 emergent scale 不一样

-

有的 task 只有 540B 的 Palm emerge

-

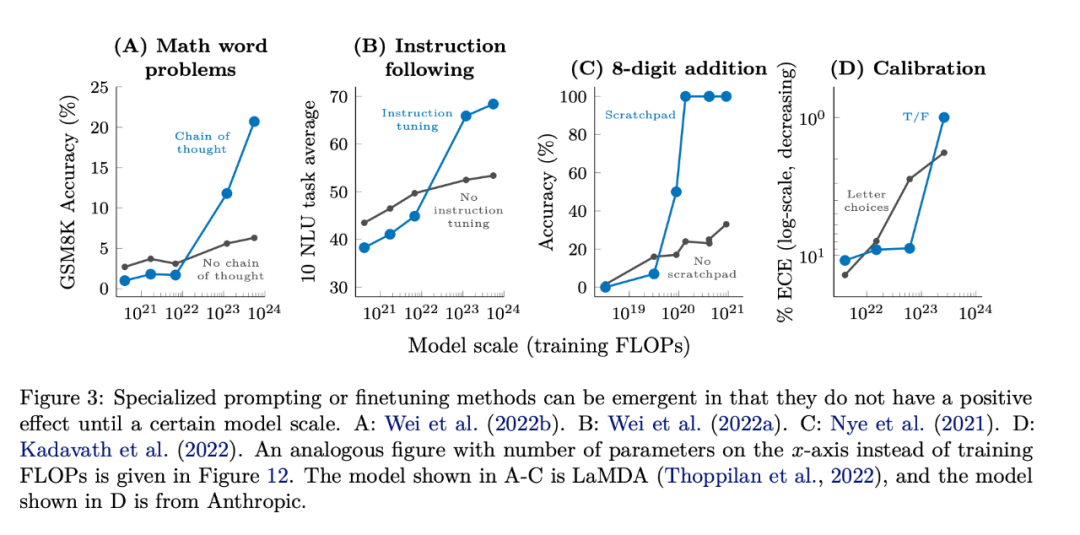

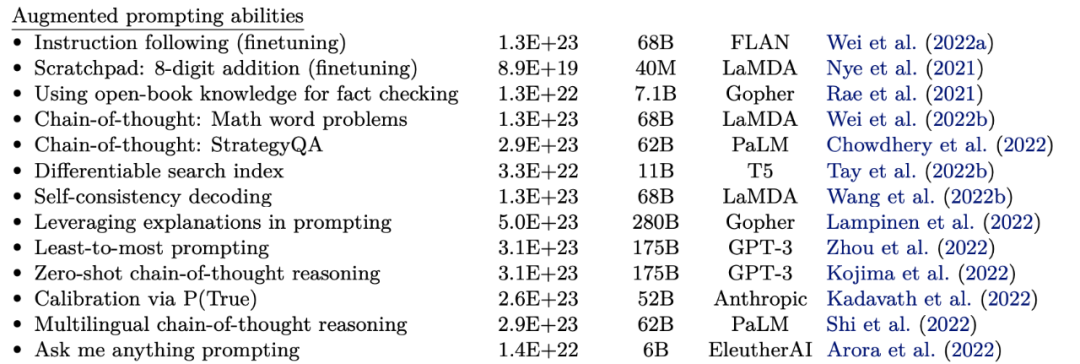

指令微调(Instruction tuning)、思维链(Chain-of-thought)等增强语言模型能力的方法都有一定程度的涌现

-

联想:之前的 prompt tuning,parameter efficient tuning,都是某种随着模型规模扩大的涌现

05 结果讨论

Emergent 现象的解释

-

多步能力说

-

指标缺陷说 -

奇怪的现象:交叉熵损失不是 emergent 的,而是在逐步下降

Emergent 的阈值可能会越来越小

更干净的数据,更好的训练技巧,更优秀的模型结构都可以使 Emergent 阈值变小

-

继续扩大模型规模,远未达到上限

-

一些新结构的 scaling、数据的 scaling

-

理解 prompt 机制

-

用更前沿的 task 来指导 emergent

-

理解 emergence

06 论文贡献

优点

局限

-

没有解释 emerge 现象到底由什么因素导致

-

实验采用各种不同模型,无法得出哪个计算量级对哪种能力有 emerge

? https://arxiv.org/pdf/2206.07682

我们为读者准备了一份高清思维导图,包括了论文中的重点亮点以及直观的示意图。点击下方名片 关注 OpenBMB ,后台发送“论文速读” ,即可领取论文学习高清思维导图和 FreeMind !

本期论文速读视频版已发布于 视频号 和 B站 (视频讲解比文字阅读更加详细易懂),欢迎大家评论和分享~

除涌现外,还发现了大模型的更多有趣特性?欢迎参与 BMPrinciples 的共建!

? https://github.com/OpenBMB/BMPrinciples

➤ 加社群/ 提建议/ 有疑问

长期开放招聘|含实习

开发岗 | 算法岗 | 产品岗