AgentBench: 评估LLMs作为Agent的能力

标题:AgentBench: Evaluating LLMs as Agents

机构:清华大学、俄亥俄州立大学、UC伯克利分校

关键词:LLMs、AgentBench、推理能力、决策能力

作者:Xiao Liu, Hao Yu, Hanchen Zhang

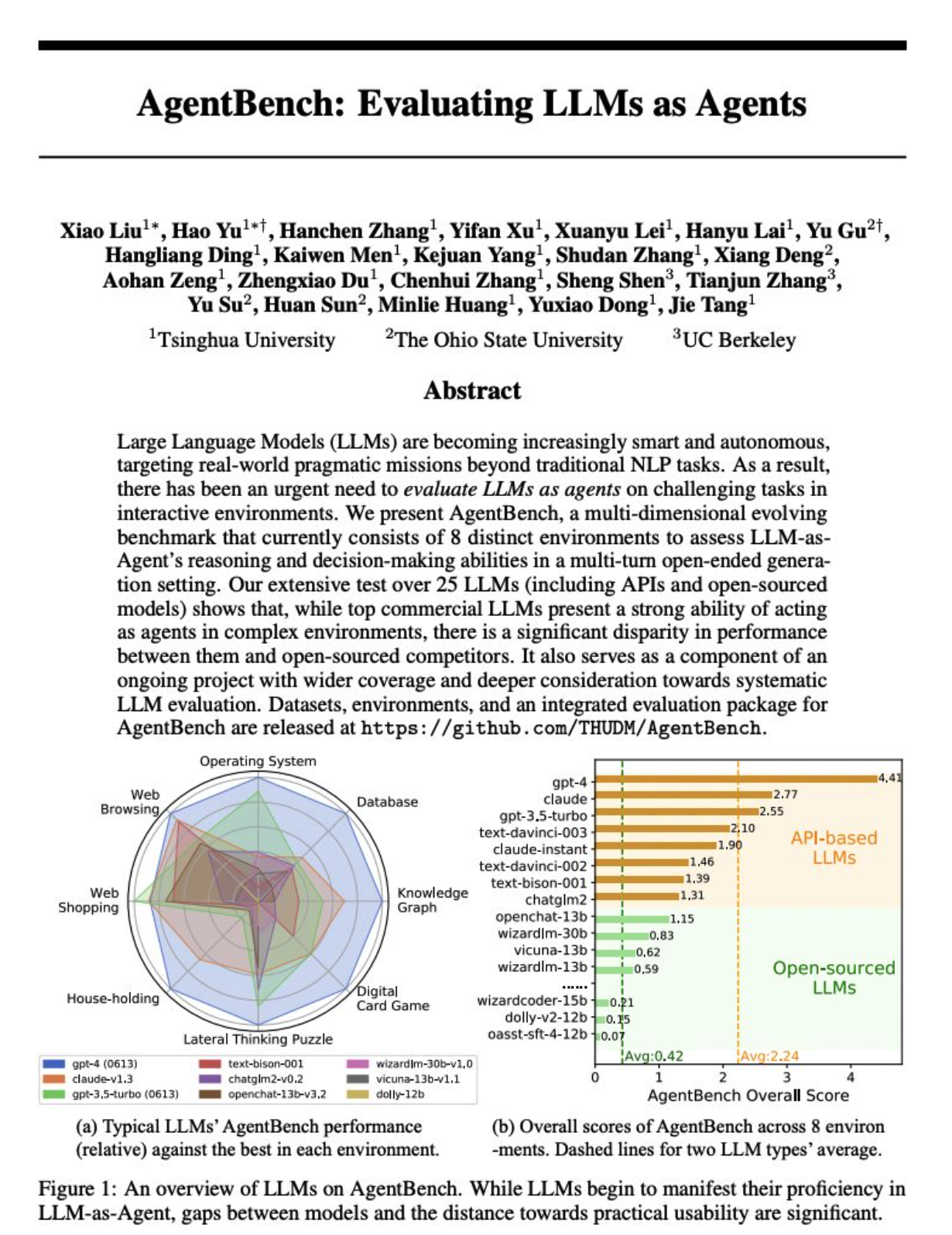

分析:该论文主要探讨大语言模型(LLMs)在多回合开放生成环境中作为Agent的推理和决策能力,并为此设计了AgentBench,一个多维度的逐步发展的评估基准。研究发现,商业LLMs在复杂环境中作为Agent表现出较强能力,但与开源竞争对手相比性能存在显著差异。该论文是对系统性LLM评估项目的组成部分。

大型语言模型(LLM)正变得越来越智能和自主,其目标是超越传统 NLP 任务的现实世界实用任务。因此,我们迫切需要对 LLMs 作为代理在交互环境中执行挑战性任务的情况进行评估。

我们提出的 AgentBench 是一个多维度的演进基准,目前由 8 个不同的环境组成,用于评估 LLM 作为代理在多轮开放式生成环境中的推理和决策能力。

我们对 25 种 LLM(包括应用程序接口和开源模型)进行的广泛测试表明,虽然顶级商业 LLM 在复杂环境中表现出很强的代理能力,但它们与开源竞争对手之间的性能差距很大。这也是一个正在进行的项目的组成部分,该项目覆盖面更广,对系统的 LLM 评估考虑更深。

地址:https://arxiv.org/pdf/2308.03688

代码:https://github.com/THUDM/AgentBench

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...